FACEBOOK BUSCA TRANSFORMAR EL MERCADO DE LAS TELECOMUNICACIONES

Resultaría extraño pensar en Facebook como una compañía de hardware. Con un foco puesto en el mercado de las redes sociales, y un dominio abrumador en las tiendas de aplicaciones móviles con su amplio portfolio de apps esta es, sin lugar a dudas, una empresa muy alejada de ese negocio. De hecho, cuando en 2013 la empresa intentó lanzar su propio smartphone, el HTC First – diseñado en conjunto con el fabricante taiwanés –no cosechó resultados muy positivos. Sin embargo, hace pocos días, la compañía anunció sus planes de meterse en este negocio. Esta vez, sin embargo, no lo hará de la mano de dispositivos orientados al consumidor, sino que de equipamiento orientado a las empresas de telecomunicaciones para el despliegue de sus redes de datos.

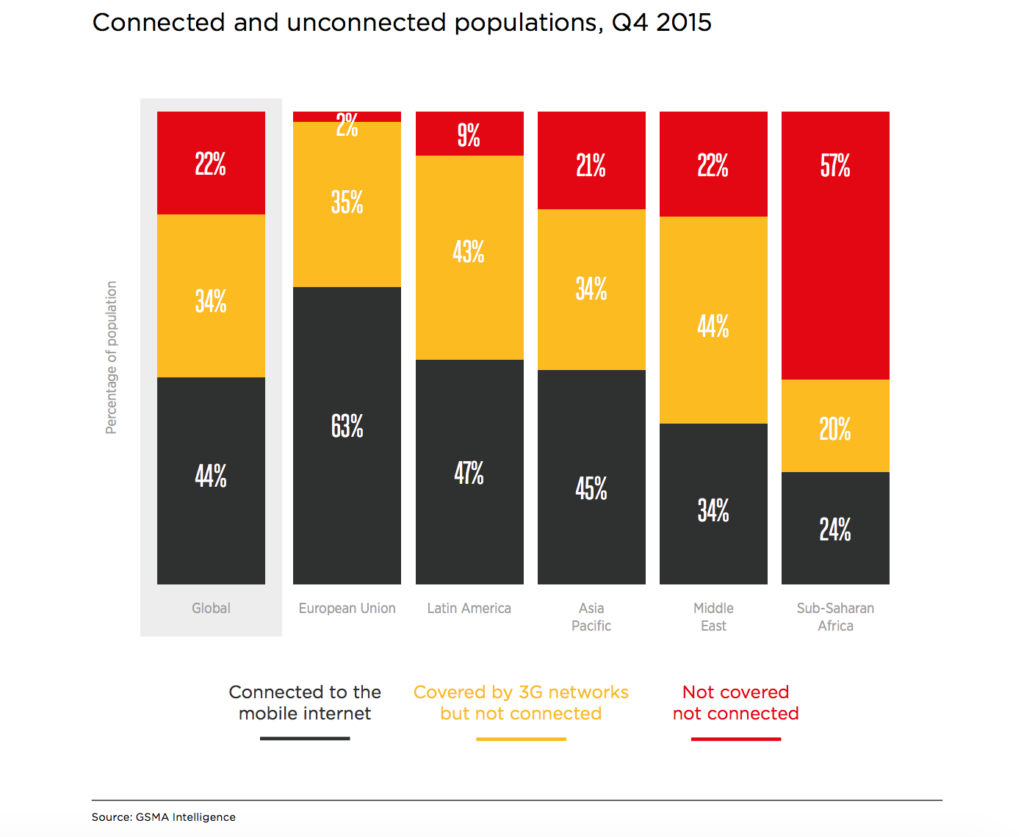

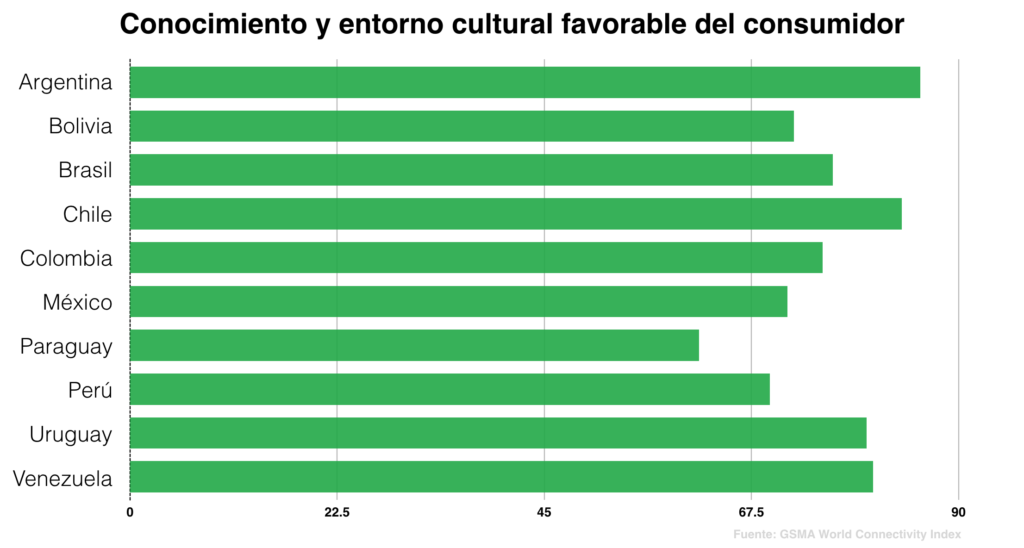

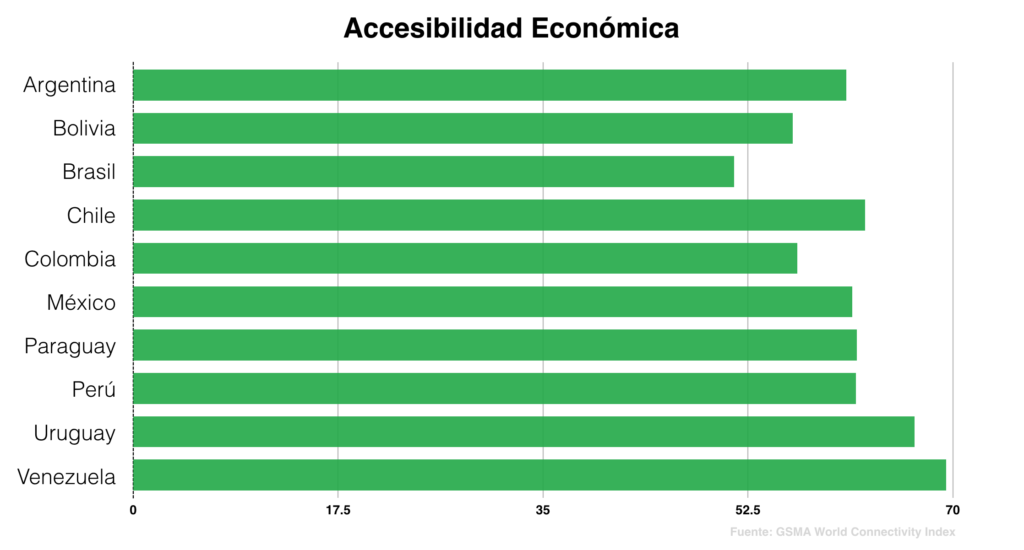

Este mercado, que a nivel mundial tiene una magnitud de $500 mil millones de dólares, hoy se encuentra dominado por empresas como Cisco, Ericsson, Huawei, Nokia, Alcatel Lucent (en manos de la anterior), y otras, y poco tiene que ver con las líneas de negocio o con el expertise de la empresa de Mark Zuckerberg. Sin embargo, el desarrollo de más y mejores redes capaces de satisfacer la creciente demanda de datos, y de conectar a los miles de millones de personas que aún se encuentran desconectadas, se alinea directamente con sus intereses. Y es que, que con más de 1.500 millones de usuarios, el crecimiento de la compañía se encuentra atado al crecimiento de Internet en general.

Es por este motivo que, aunque busca revolucionar las telecomunicaciones, el objetivo principal de Facebook no radica en desarrollar un nuevo canal de ingresos. En cambio, la posibilidad de ayudar a las operadoras y otras telcos a expandir las redes móviles, sobre todo en nuevos mercados, la llevará a obtener beneficios indirectos, a través de la captación de nuevos usuarios para sus aplicaciones.

“La misión de Facebook – escribió la compañía en su blog de ingeniería – es hacer un mundo más abierto y conectado, ya sea mediante el desarrollo de tecnología que permita conectar a los desconectados, o crear experiencias inmersivas que requieren de mejores conexiones. Con el crecimiento en el consumo de video y de realidad virtual, es necesario desarrollar redes más grandes y mejores. Este es un desafío increíble, y en los próximos años todos debemos trabajar juntos para comprender los desafíos específicos de la conectividad en cada mercado, y para desarrollar tecnologías y procesos que los puedan resolver”.

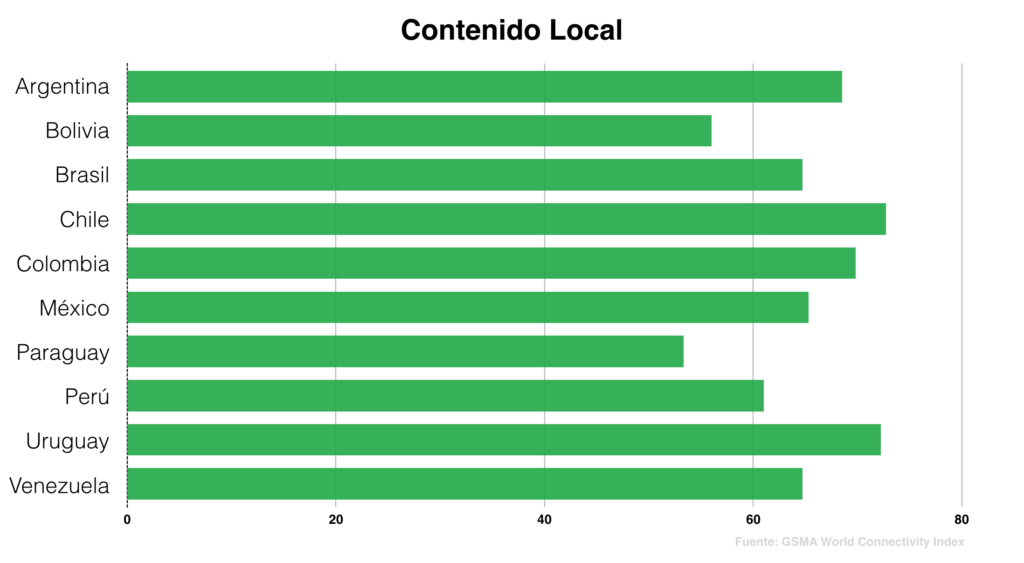

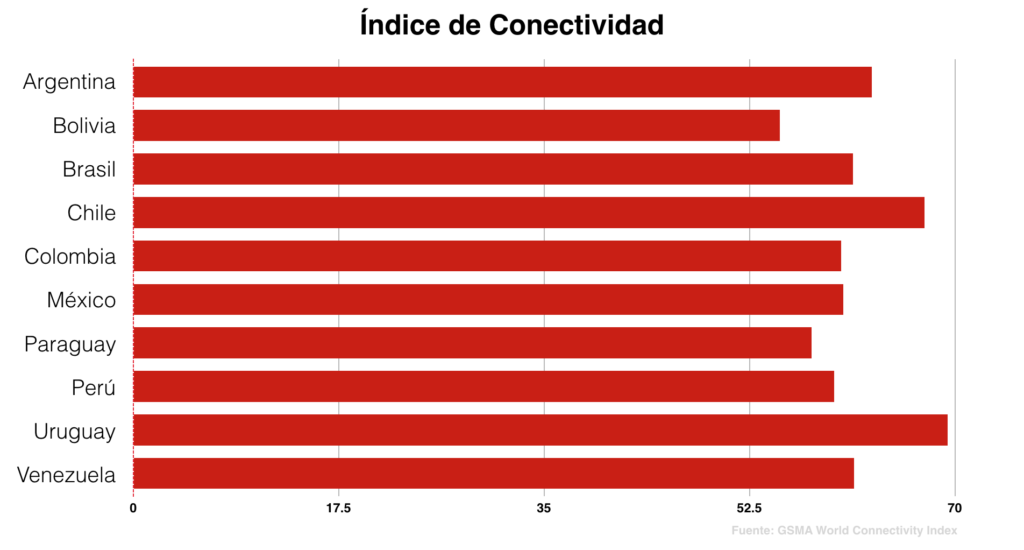

Más allá de sus necesidades individuales, Facebook tiene razón en querer apalancar esta tecnología. Y es que la creciente demanda de datos, propulsada por el consumo de video, llevará a que globalmente el tráfico de datos móviles crezca de 6.765 Petabytes por mes en 2016 a 24.313 Petabytes por mes en 2019, según datos de GSMA. El crecimiento de la Internet de las Cosas, pero especialmente de nuevas tecnologías como la realidad virtual y la realidad aumentada incrementarán aún más esa demanda, por lo que hará falta un ancho de banda mayor para poder suplirla.

La primera innovación de Facebook en ese sentido es Voyager, un transponder óptico (u optical swtich, por su nombre en inglés), es decir una pieza de equipo que toma paquetes de otros switches y routers y los prepara para enviarlos a través de un único cable de fibra óptica. Los mismos se utilizan tanto dentro de redes metropolitanas, las cuáles conectan distintos centros de distribución dentro de la misma ciudad, o para el transporte de los datos a través de largas distancias. La tecnología que permite hacer esto se llama DWDM (Dense Wavelength-Division Multiplexing, o Multiplexado compacto por división en longitudes de onda) la cual, en pocas palabras, combina distintas señales ópticas en un mismo cable de fibra óptica utilizando distintas longitudes de onda para cada una de ellas.

El desarrollo de esta tecnología, la cual ha avanzado a pasos agigantados desde los años 90s, ha comenzado a detenerse durante los últimos años, a medida que nos acercamos a los límites de la eficiencia del espectro. Es por eso que Facebook, con su nuevo producto, busca cambiar el enfoque que ha tenido la industria hasta el momento, el cual consiste en la producción de equipos cuyo hardware y software se encuentran confinados a entornos cerrados. El nuevo producto de Facebook busca cambiar eso, desacoplando el software del hardware, y utilizando una filosofía de código abierto, para permitir que cualquier compañía pueda desarrollar sobre el dispositivo. Por ese motivo la compañía ha catalogado a este producto como un “White box” (una caja blanca), en contraste con la caracterización genérica de “Black box” (caja negra) que suelen recibir este tipo de equipos, y que hacen referencia a su entorno cerrado.

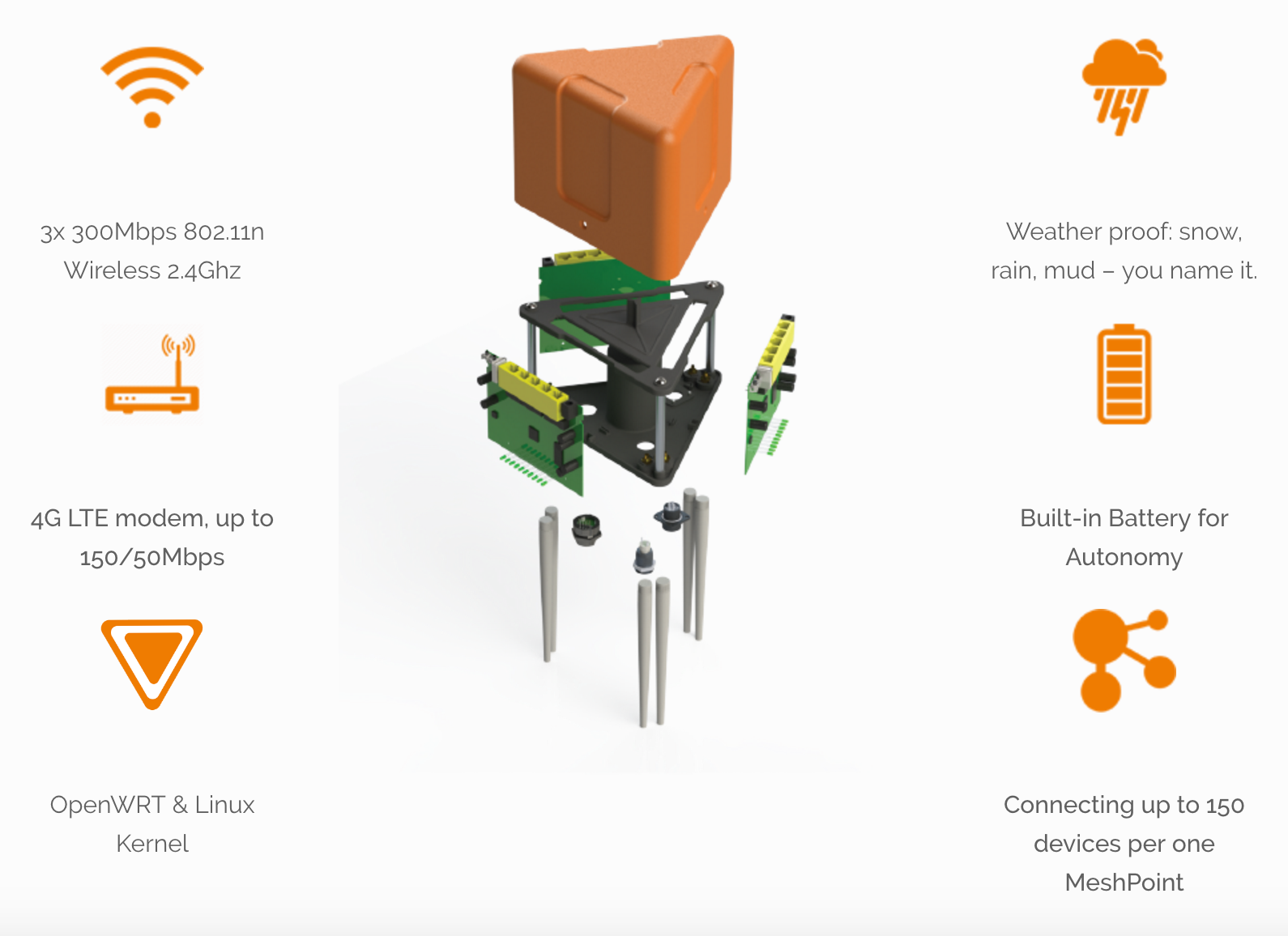

Del mismo modo, Facebook apunta a generar una cultura colaborativa en torno al diseño del hardware necesario para el despliegue de las redes, y sobre su implementación. De esta forma, busca que las empresas puedan aprender unas de las otras, y optimizar entre todas los procesos y tecnologías necesarias para su despliegue y operación. Al mismo tiempo, la empresa se encuentra trabajando en la creación de otras piezas de hardware, y en el desarrollo de una red móvil de código abierto, para lo cual está colaborando con distintas compañías en el campo de la infraestructura y el software, a través de una iniciativa llamada Telecom Infra Project, la cual presentó en el Mobile World Congress en Barcelona en 2016.

Esta no es la primera vez que Facebook hace algo de este estilo. En 2011, en plena expansión de sus data centers, la compañía lanzó el Open Computer Project, u OCP, una iniciativa para convertir el hardware necesario para armar este tipo de centros de datos en tecnologías de código abierto. El objetivo consiste en ayudar a que las compañías que operan este tipo de centros puedan beneficiarse construyendo sus propios equipos a través de piezas disponibles en el mercado, y aprendiendo unas de otras. Hasta ese entonces, el diseño de los data centers se tomaba como secretos industriales, y rara vez una empresa podía aprender de las experiencias de otras, o de los desarrollos internos realizados por sus competidores para optimizar sus procesos.

El proyecto fue un verdadero éxito, e hizo temblar por completo a la industria. Una gran cantidad de compañías se sumaron al OCP, especialmente los bancos e instituciones financieras, las cuales utilizan decenas de miles de servidores para procesar las millones de transacciones financieras realizadas por sus clientes, y también otros en el campo de la tecnología. Recientemente, LiknedIn también se sumó al movimiento, a través del lanzamiento del Project Altair, un proyecto interno para el desarrollo de su propia infraestructura.

Llevando esta filosofía al móvil, Facebook busca facilitar el avance de las nuevas tecnologías, su adopción por parte de las operadoras y otras compañías de telecomunicaciones y, en definitiva, acelerar la expansión de la cobertura móvil, a costos más bajos. De este modo, espera, cada vez más personas tendrán acceso a Internet a través de sus móviles, a una mayor velocidad, y con mayor capacidad de transmitir y recibir enormes cantidades de datos a bajo costo. Algo que, indirectamente, puede repercutir en grandes beneficios para su modelo de negocios.